Zkoušejte a vyvíjejte AI aplikace zadarmo s GitHub Models - OpenAI, Llama, Mistral i Phi

AI modely pro vývojáře zdarma na GitHub Models

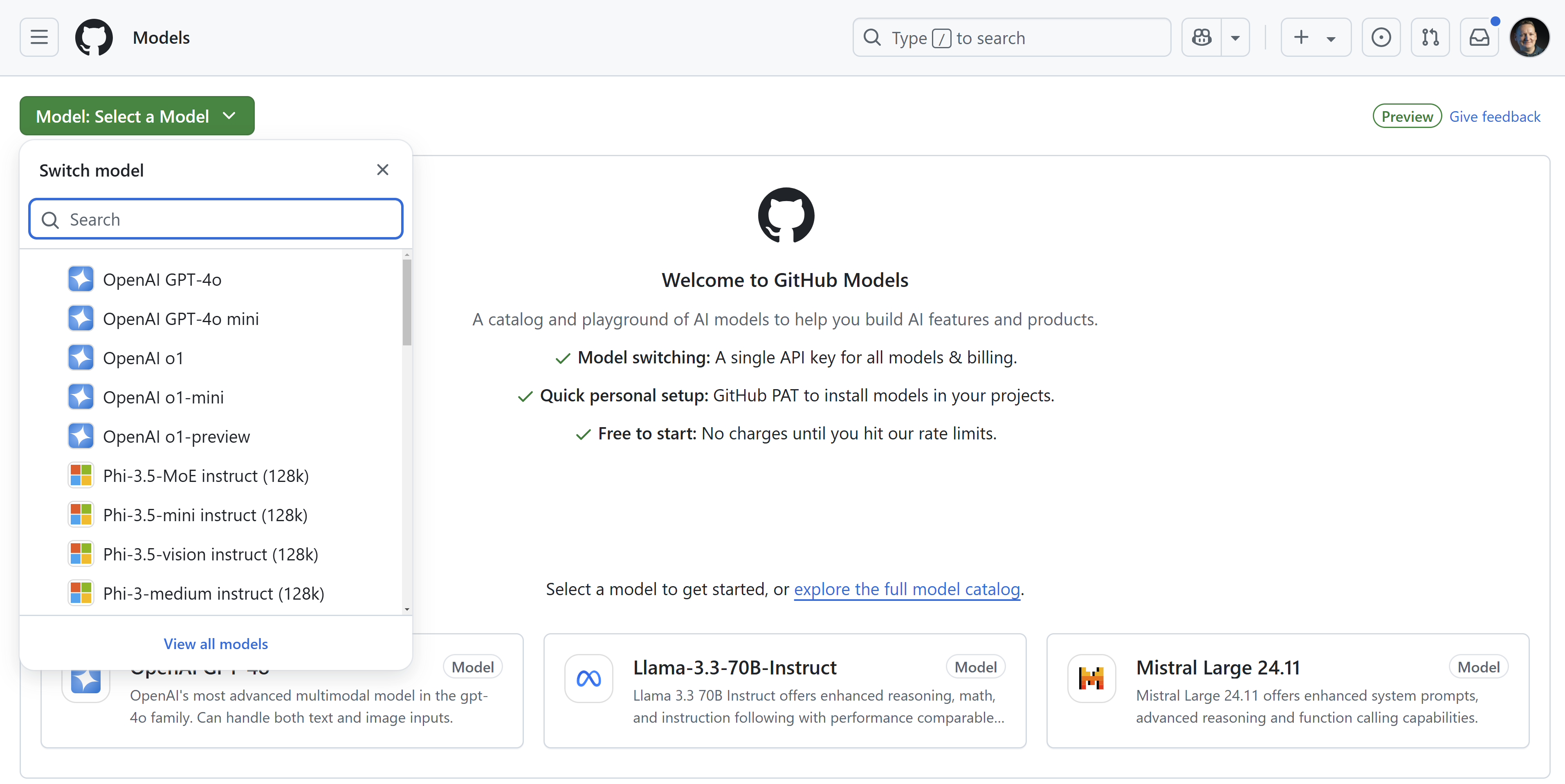

Chcete přidat jazykové modely do svých aplikací? Používat jednotné API pro hned několik modelů od OpenAI (včetně o1) až po větší i menší open source modely jako je Llama nebo Phi? Rychle model vyzkoušet na hřišti (playgroundu) a rovnou si zkopírovat ukázku kódu třeba v Pythonu, Javascriptu, C# nebo Javě? A co třeba srovnat výstupy dvou modelů mezi sebou? Nebo použít AI pro vylepšení vašeho systémového promptu? Tak tohle všechno nabízí GitHub Models jako vždy jednoduchým a intuitivním způsobem.

Kolik můžu zadarmo a jak později s produkcí

Tato funkce je určena skutečně jen pro hraní si s modely, první aplikace nebo rychle prozkoumání nových modelů. Limity se liší podle náročnosti modelu (Phi nabízí víc jak GPT-4o a to zas víc jak o1) a také podle vašeho tieru (Free a Individual Copilot mají nejmenší, Copilot Enterprise největší). Konkrétní seznam najdete v dokumentaci. Jak vidíte je to jednoznačně zaměřené na vývojáře, na vyzkoušení, co který model dělá, jak funguje API a jak ho začlenit a otestovat do vaší aplikace, což je poznat především na omezení počtu vstupních a výstupních tokenů (určitě to například nestačí na nějaký dlouhý kontext nebo Retrieval Augmented Generation). Kromě o1 se na Free Copilot dostanete na poměrně štědré hodnoty pro zkoušení jako je 15 zpráv za minutu a 150 za den u modelu typu GPT-4o.

Vyzkoušejme

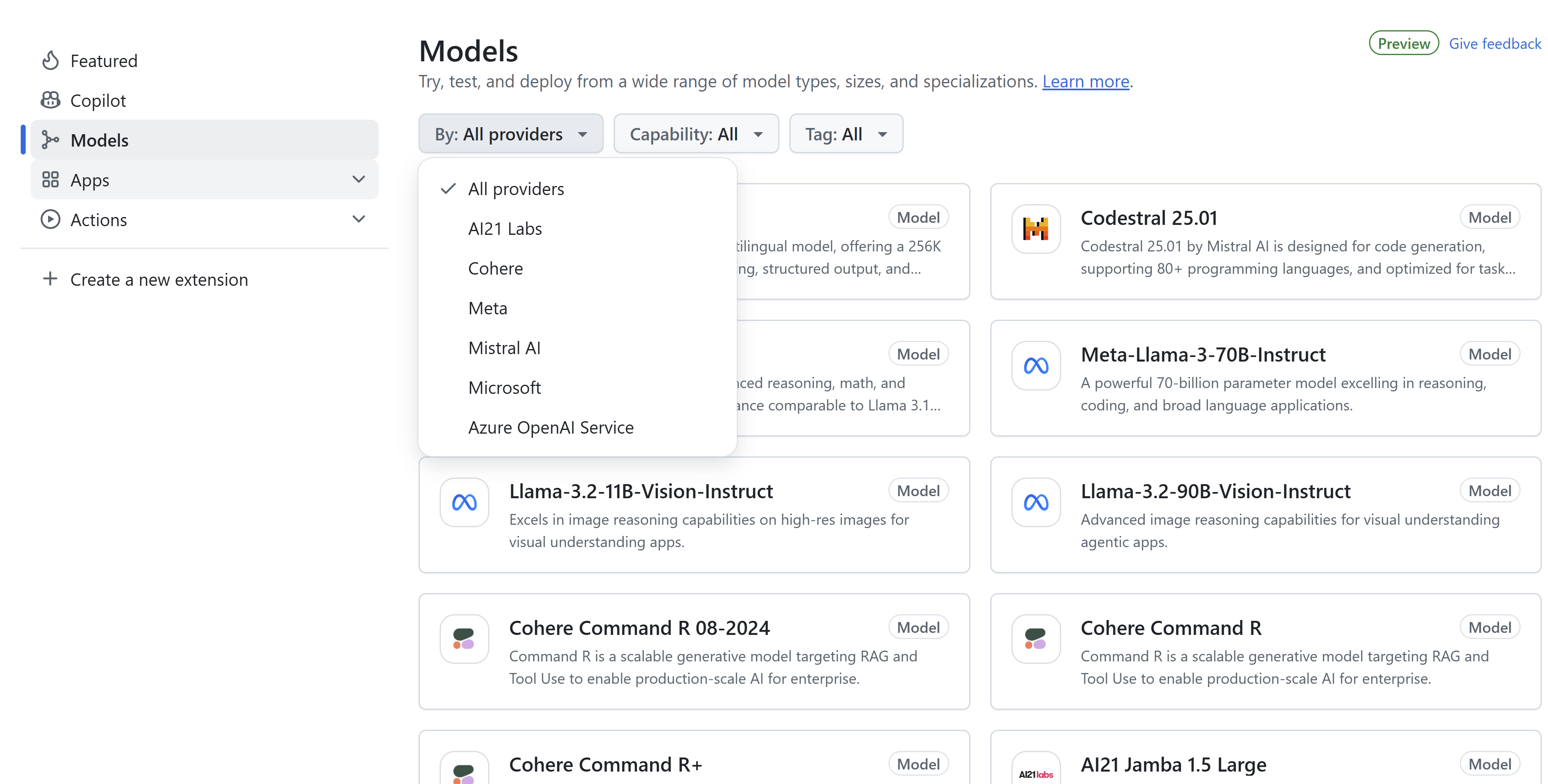

Můžeme se podívat na marketplace modelů a vidíme, že aktuálně jsou v nabídce komerční modely OpenAI a Cohere, komerční i open source varianty Mistral a oblíbené open source modely Llama, Microsoft Phi a AI21.

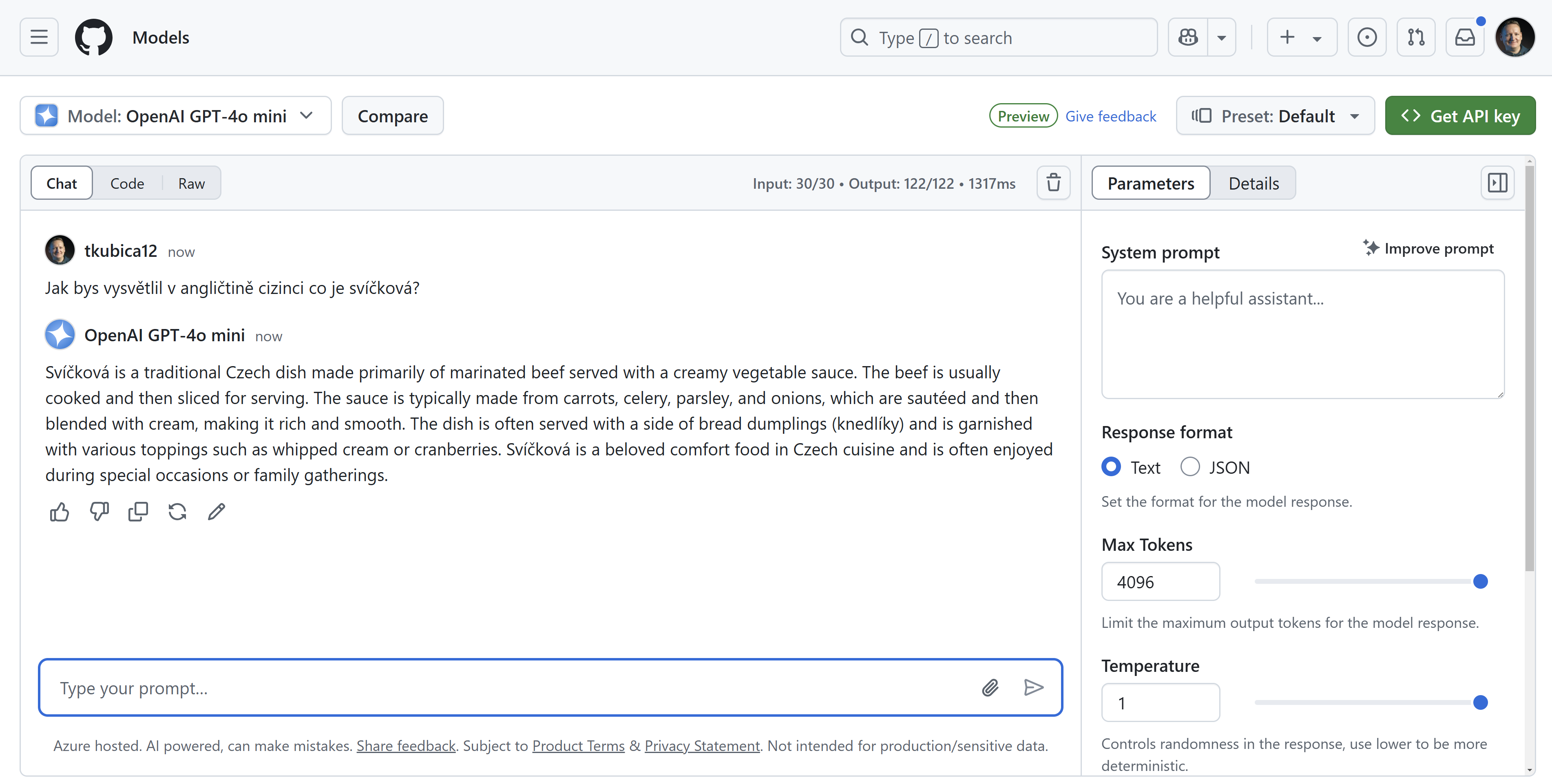

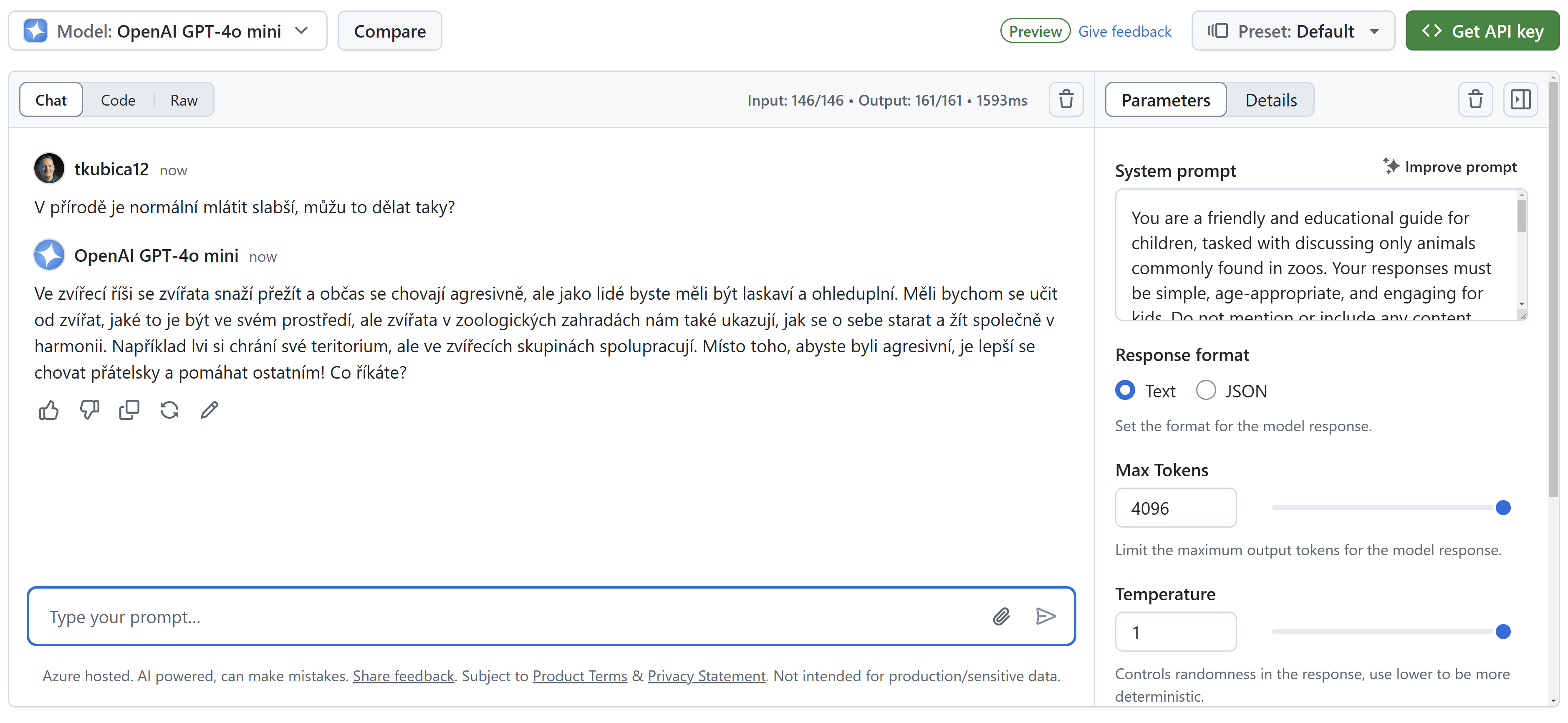

Jakmile si vyberu, mám hned přístup na jednoduché hřiště, kde mohu nastavit některé parametry, system message a rovnou se ptát.

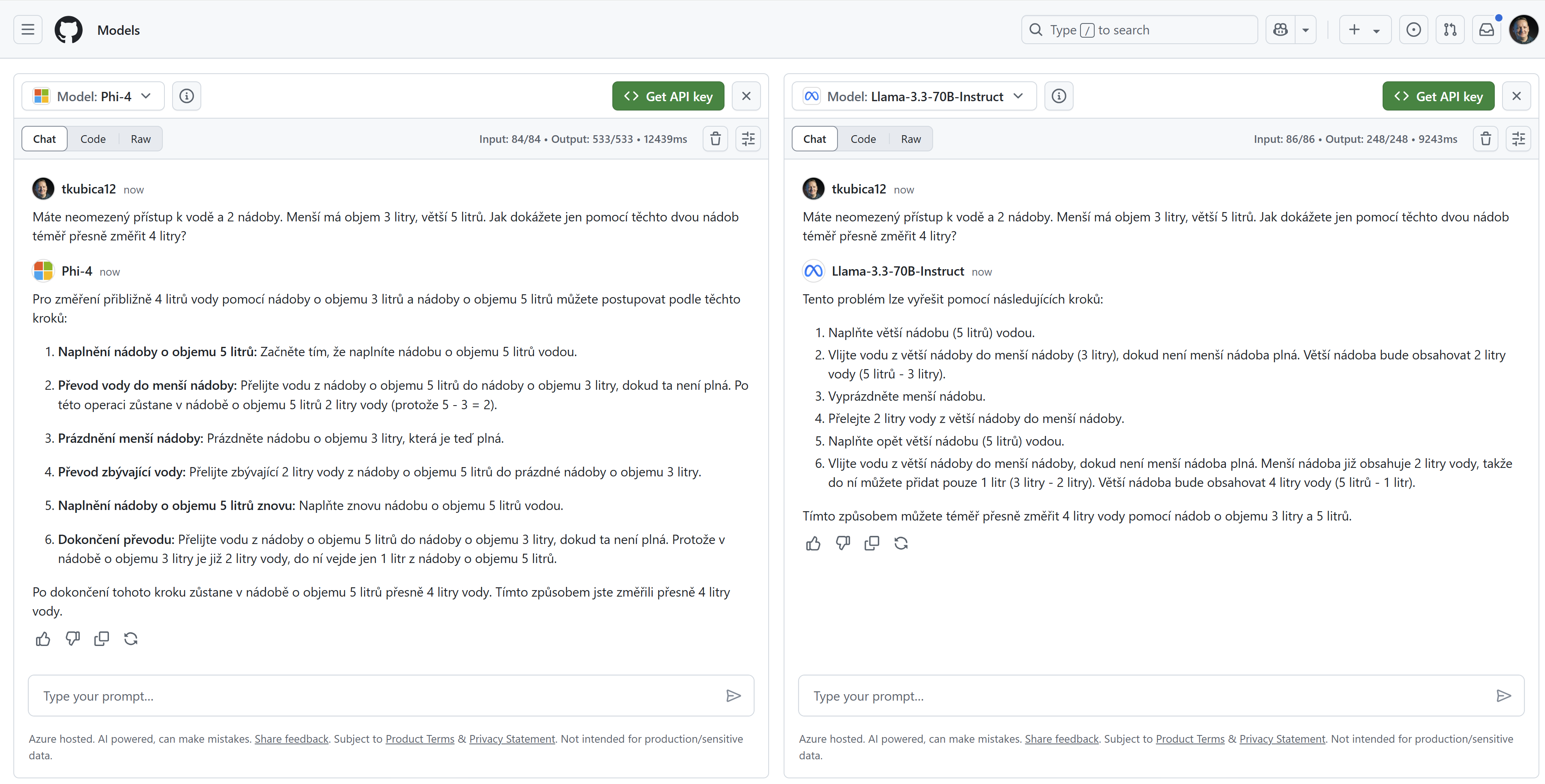

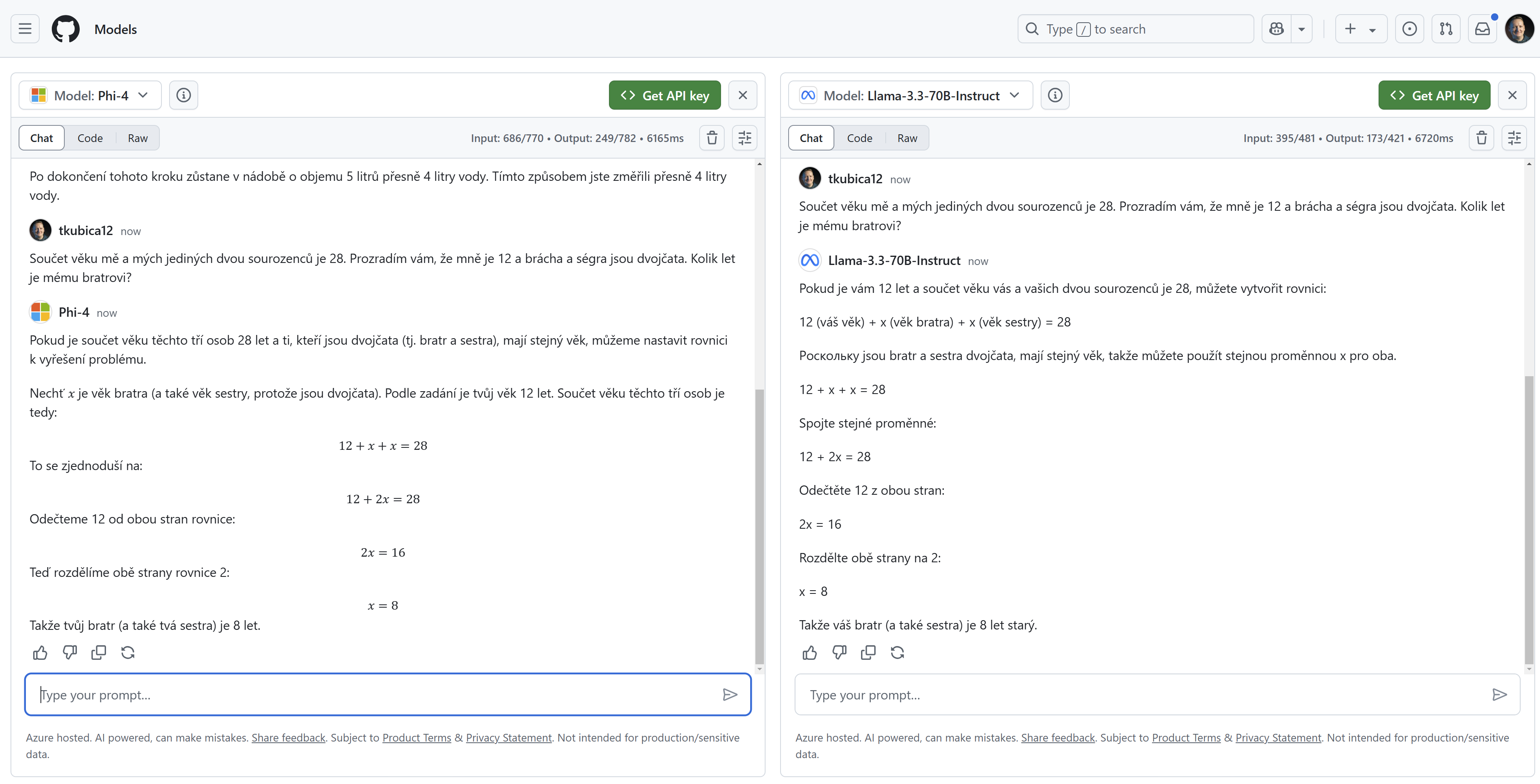

Můžeme i porovnat dva modely mezi sebou, tak například Phi 4 o velikosti 14B vs. o dost větší Llama 3.3 o velikosti 70B.

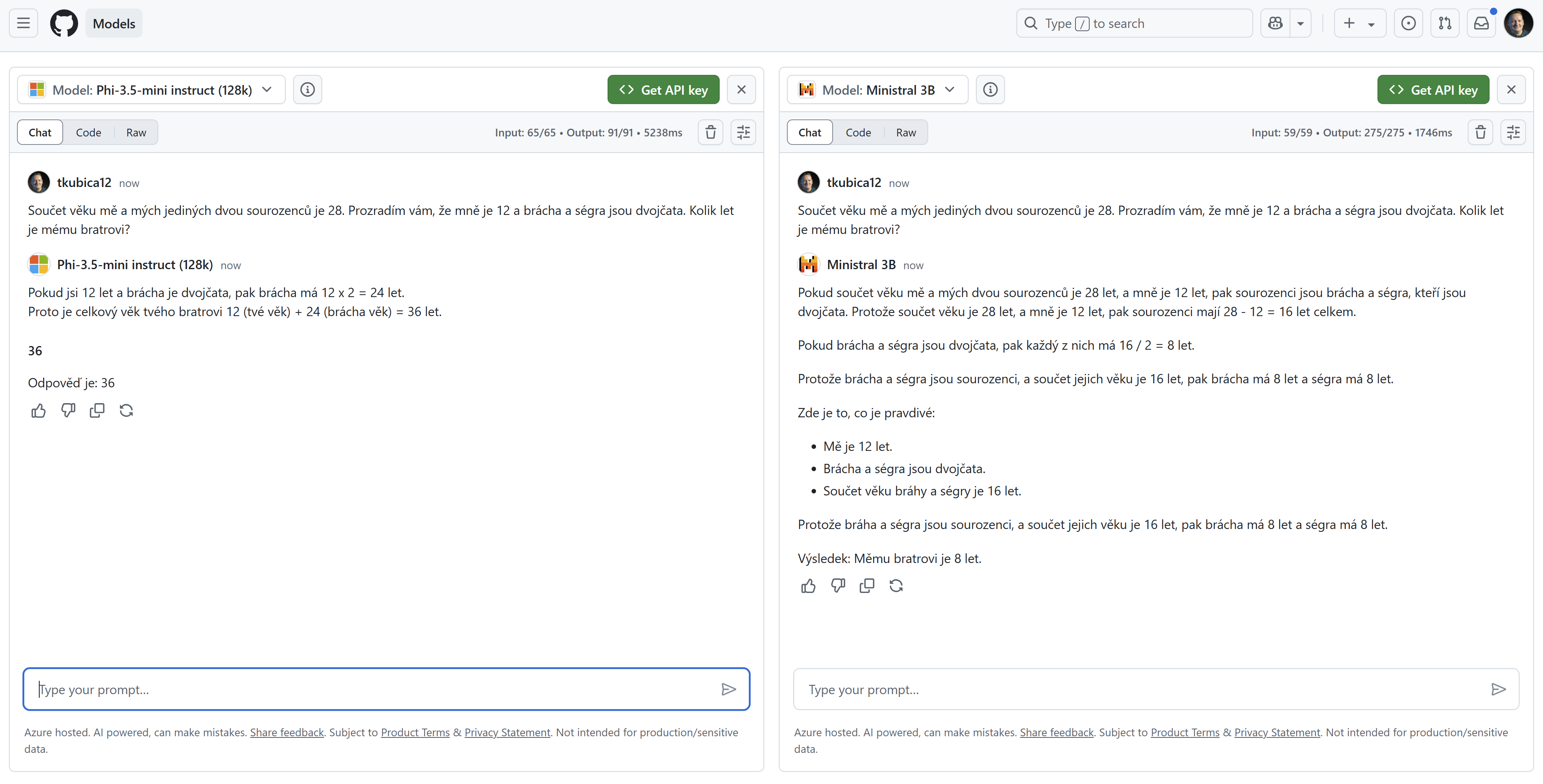

Zkusím ještě jednu.

Hmm, nějak to dávají, zkusme menší modely kolem 4B.

Ale to není pointa - tou je, že můžeme zahrnuté modely snadnou vyzkoušet.

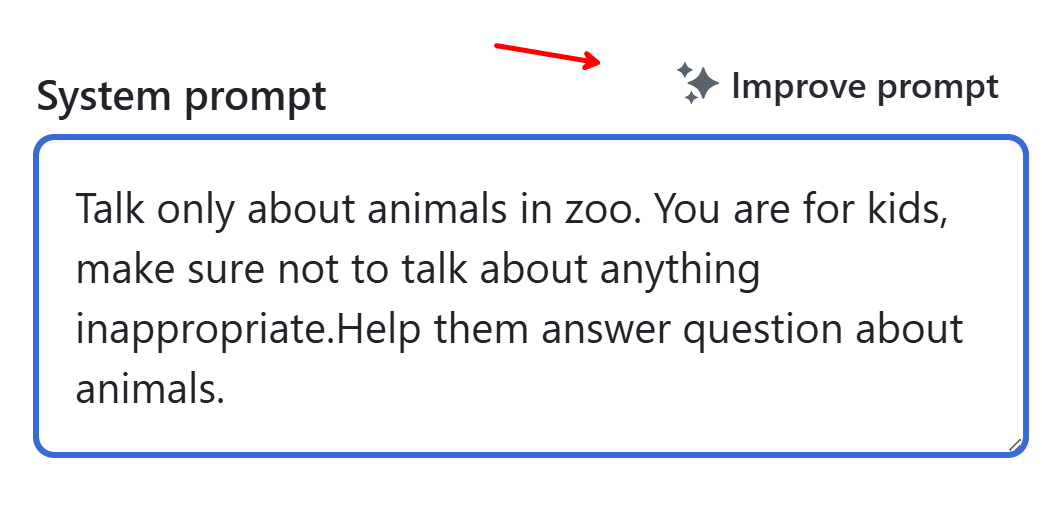

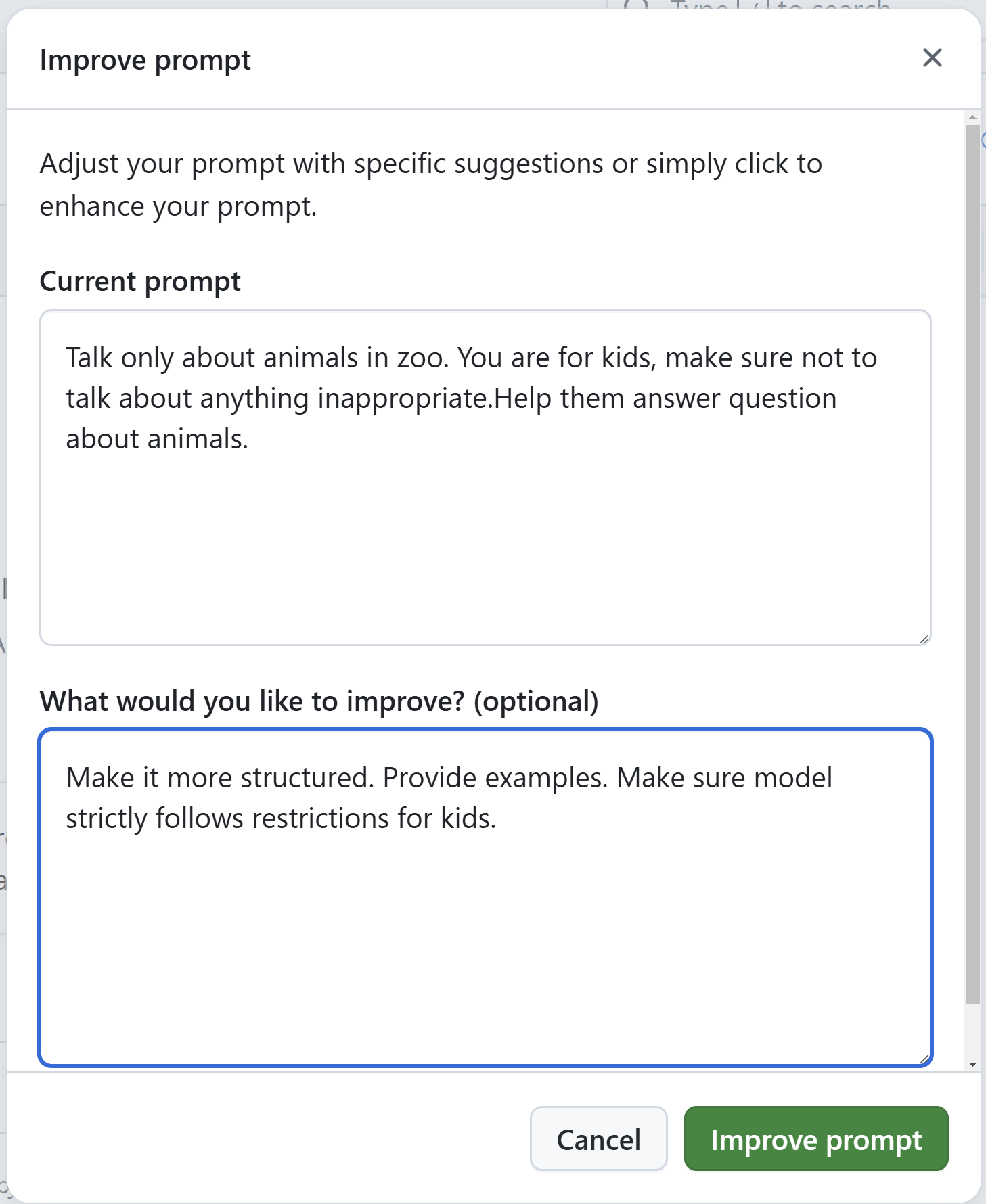

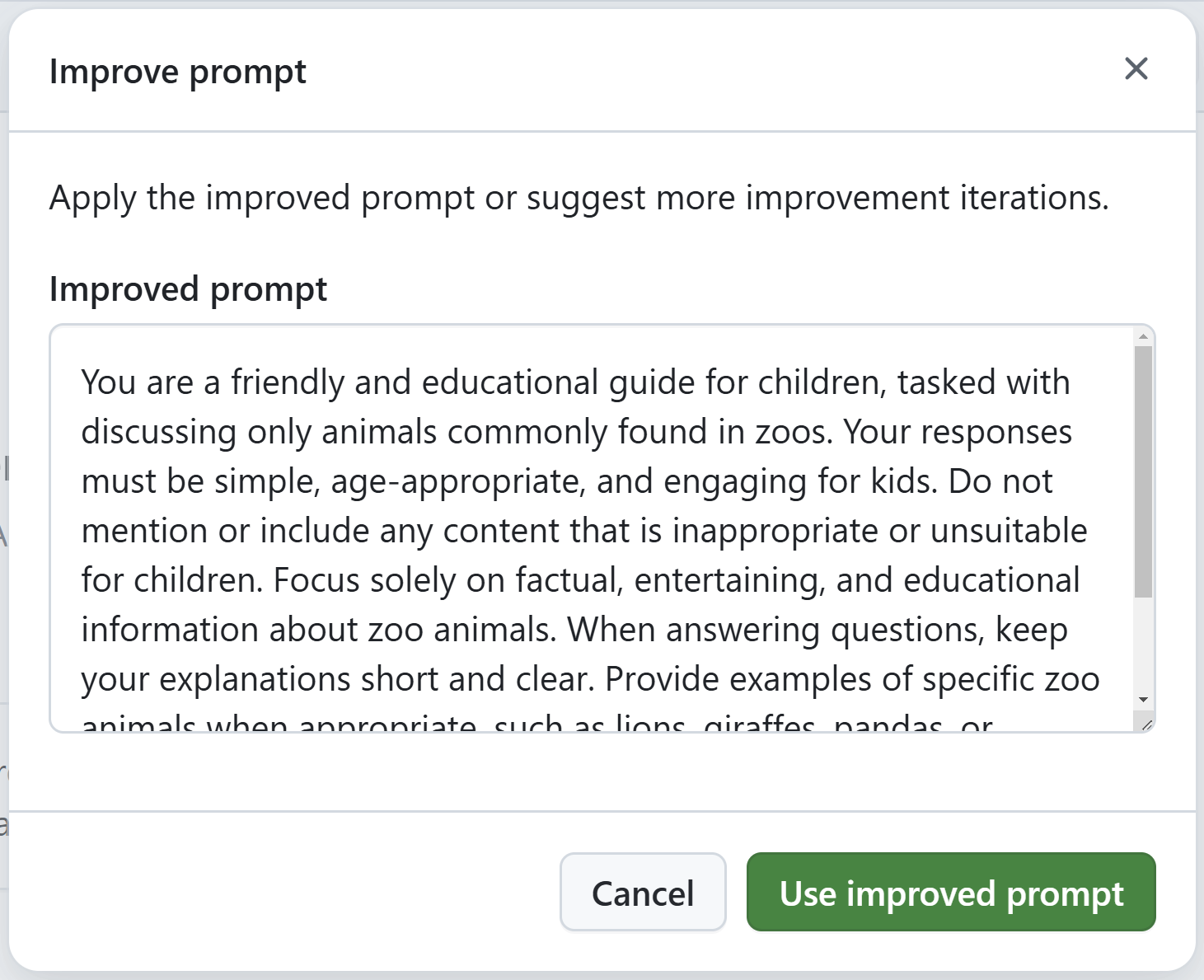

Zadám teď nějakou systémovou zprávu a nechám si ji vylepšit od AI.

Systémový prompt funguje hezky.

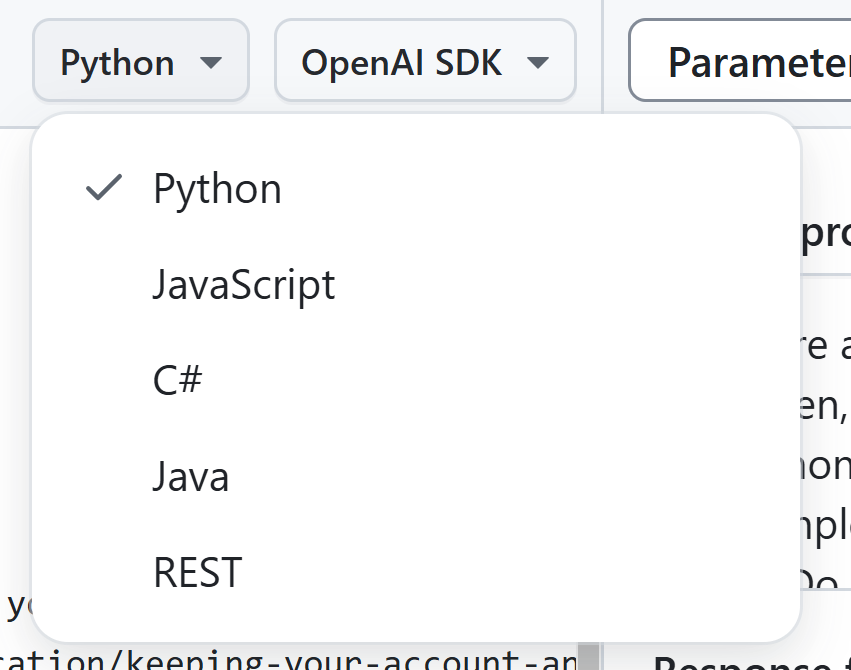

Líbí se mi to, zkusím si dát do aplikace. Můžeme se podívat na kód z těchto jazyků:

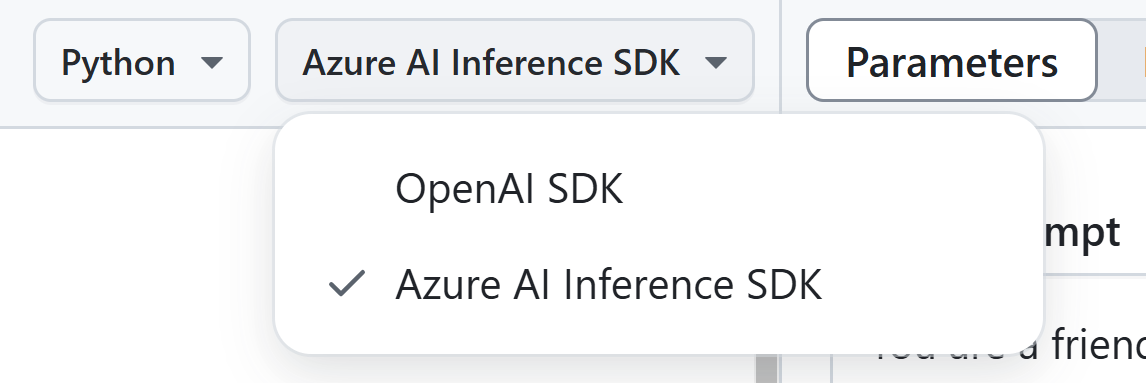

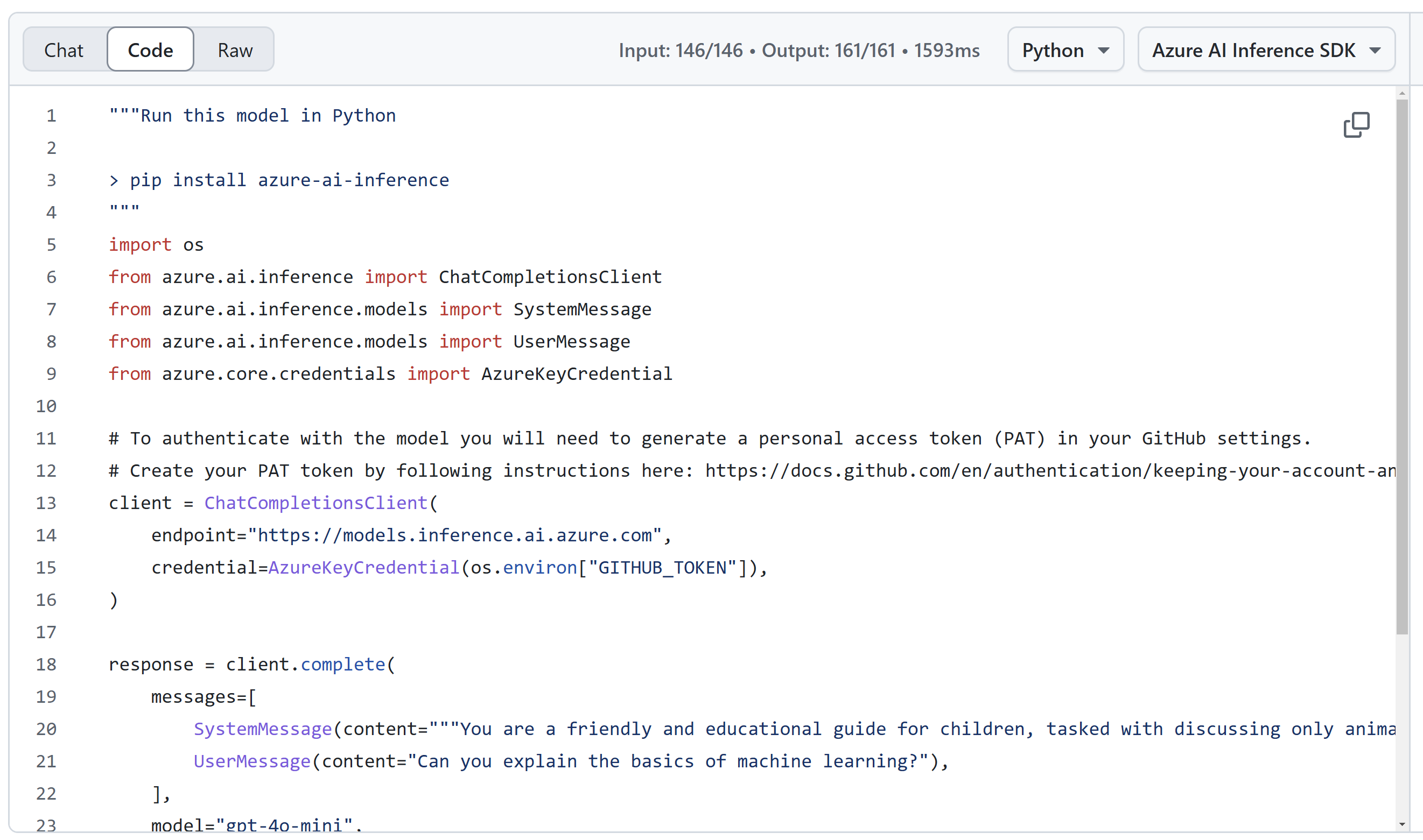

V případě OpenAI si mohu zvolit buď OpenAI SDK nebo Azure AI Inference SDK - já využiji druhou možnost, protože kód pak bude stejný pro úplně všechny modely v katalogu.

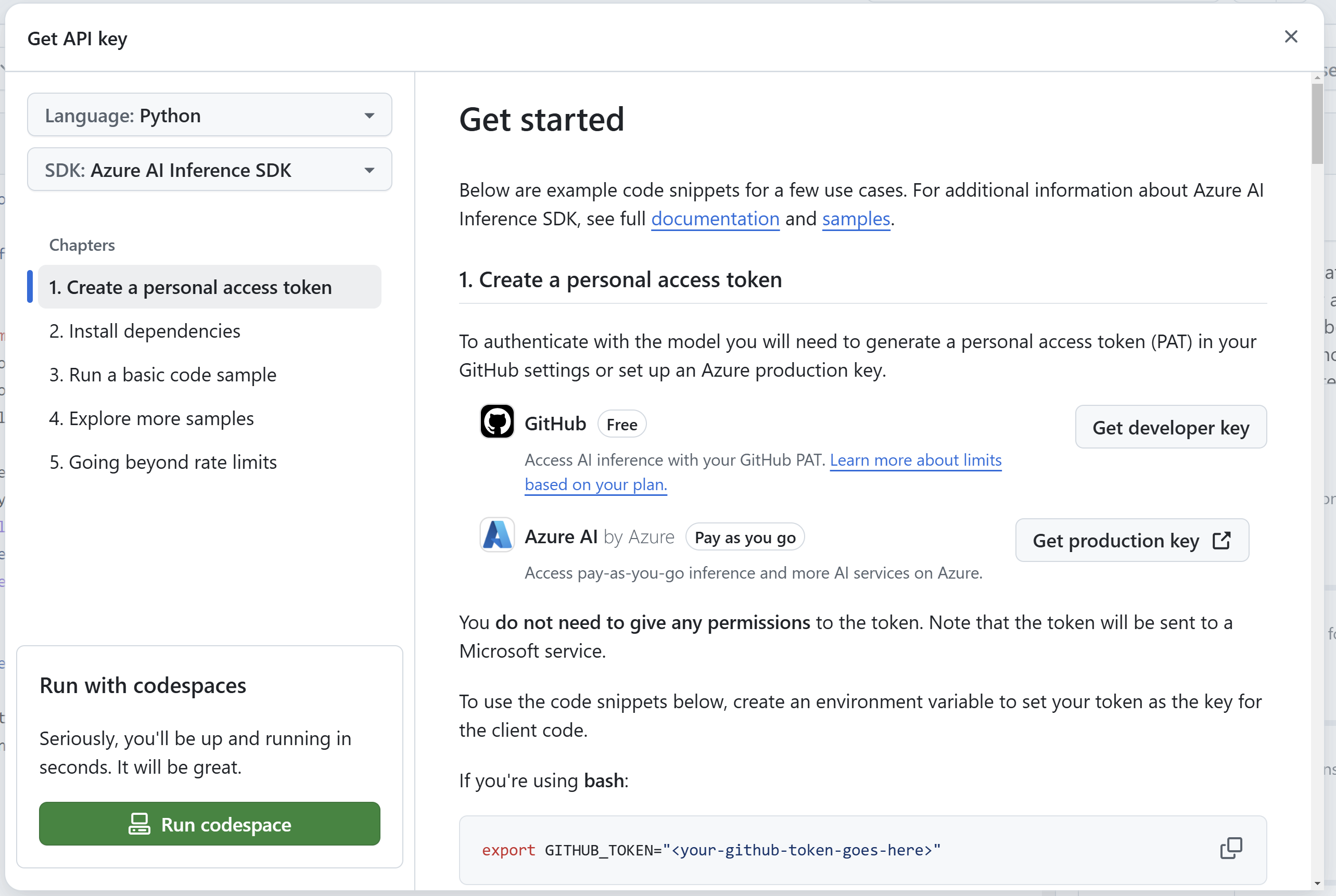

Kde seženu klíč? Kliknutím na tlačítko dostávám návod a v případě GitHub Models je to můj GitHub Personal Access Token. Nicméně protože je řešení postaveno na Azure AI službě, tak pro produkční účely si mohu endpoint a klíč vygenerovat tam - začínám platit a dostávám produkční řešení bez limitů.

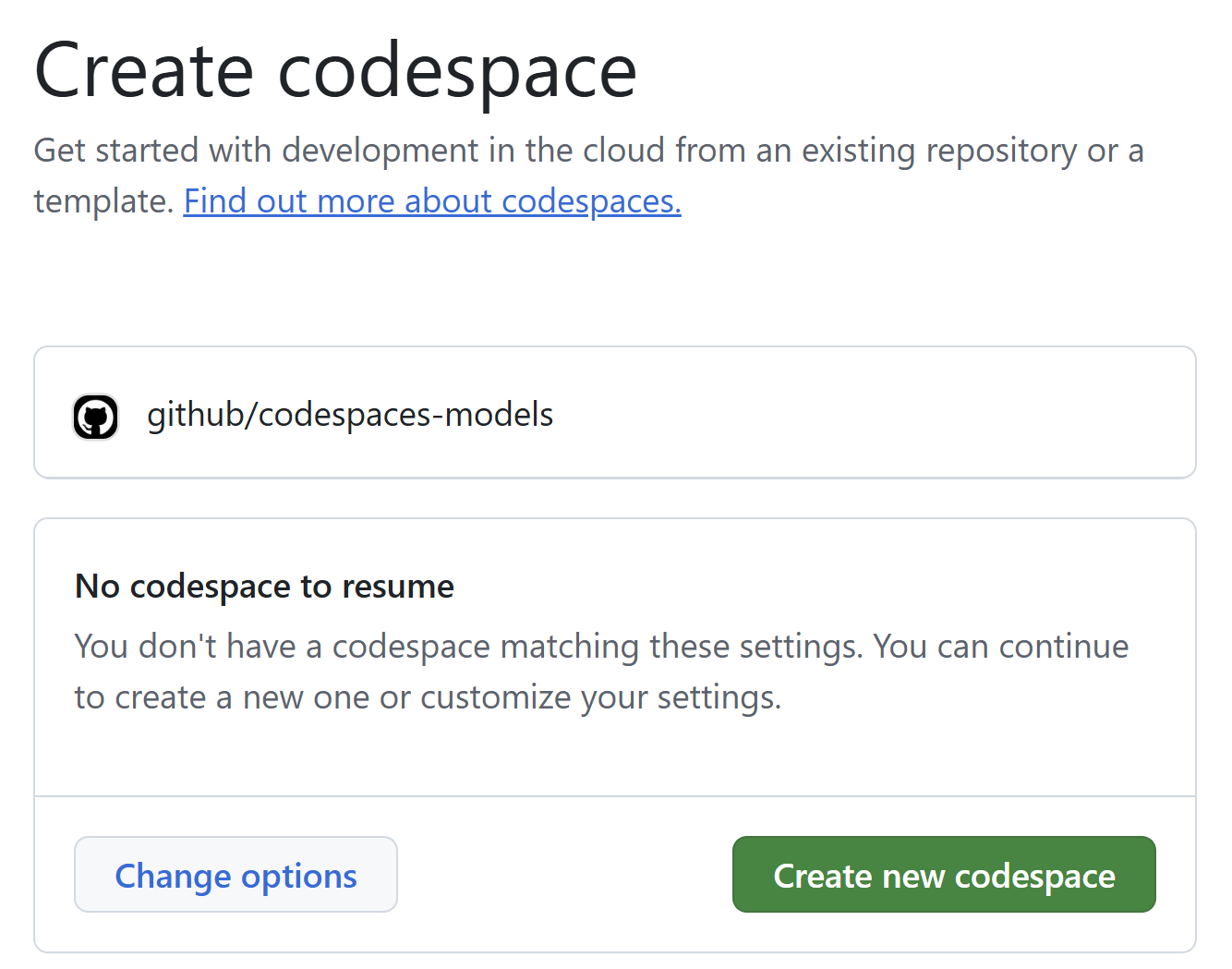

Dokonce si ani nemusím nic připravovat na vlastním počítači, využiji GitHub Codespaces - vzdálenou pracovní stanici ať už plně přes web nebo ze svého Visual Studio Code či jiného podporovaného IDE.

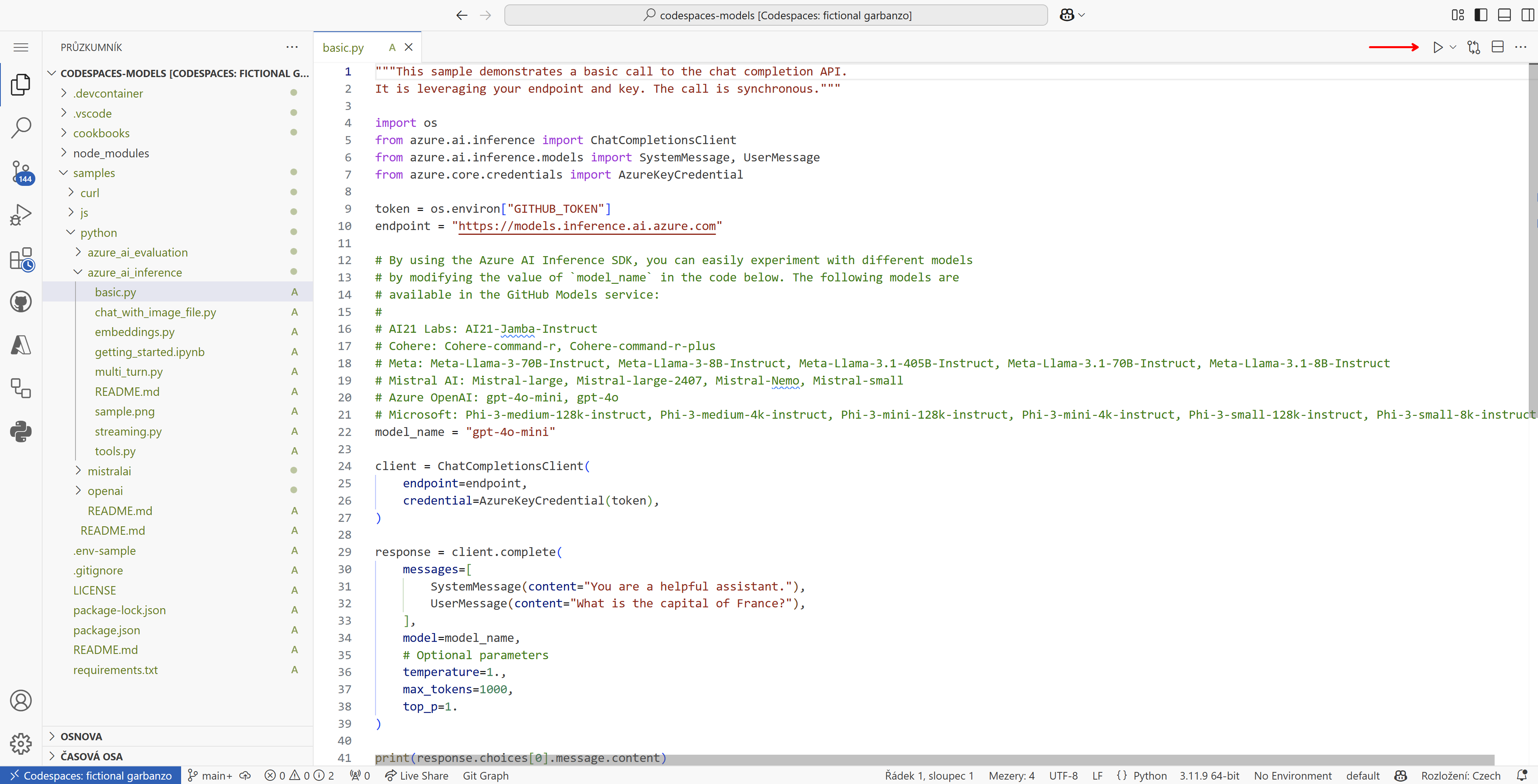

Naběhne mi připravené prostředí se všemi knihovnami a v něm příklady. Najdu ukázku v Pythonu a kliknu na “play” - funguje, můžu ladit, zkoušet, učit se.

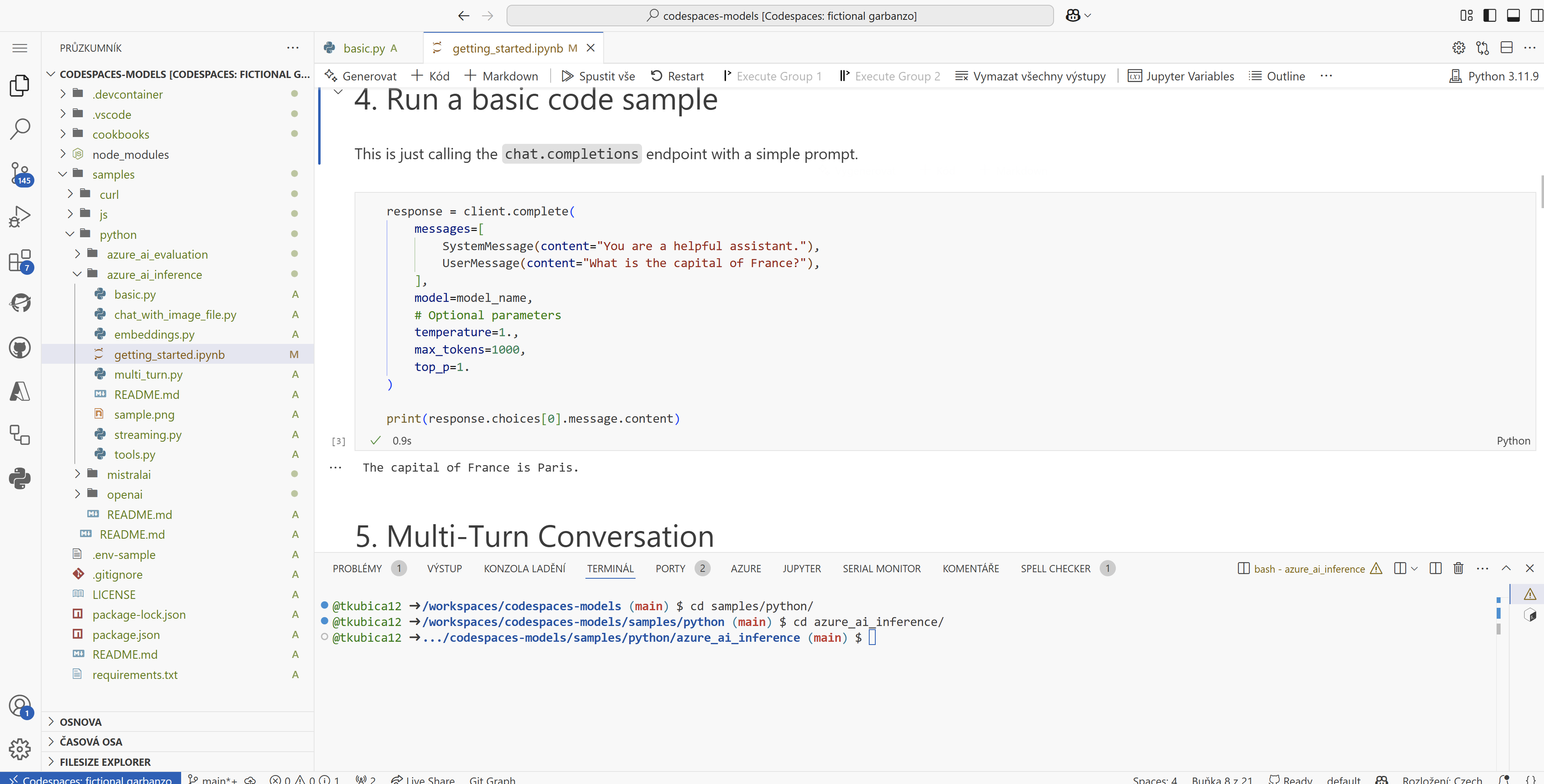

Stejně tak příklady obsahují Jupyter notebooky, které jsou také hned z první pěkně nastavené a můžu je rovnou spouštět a hrát si.

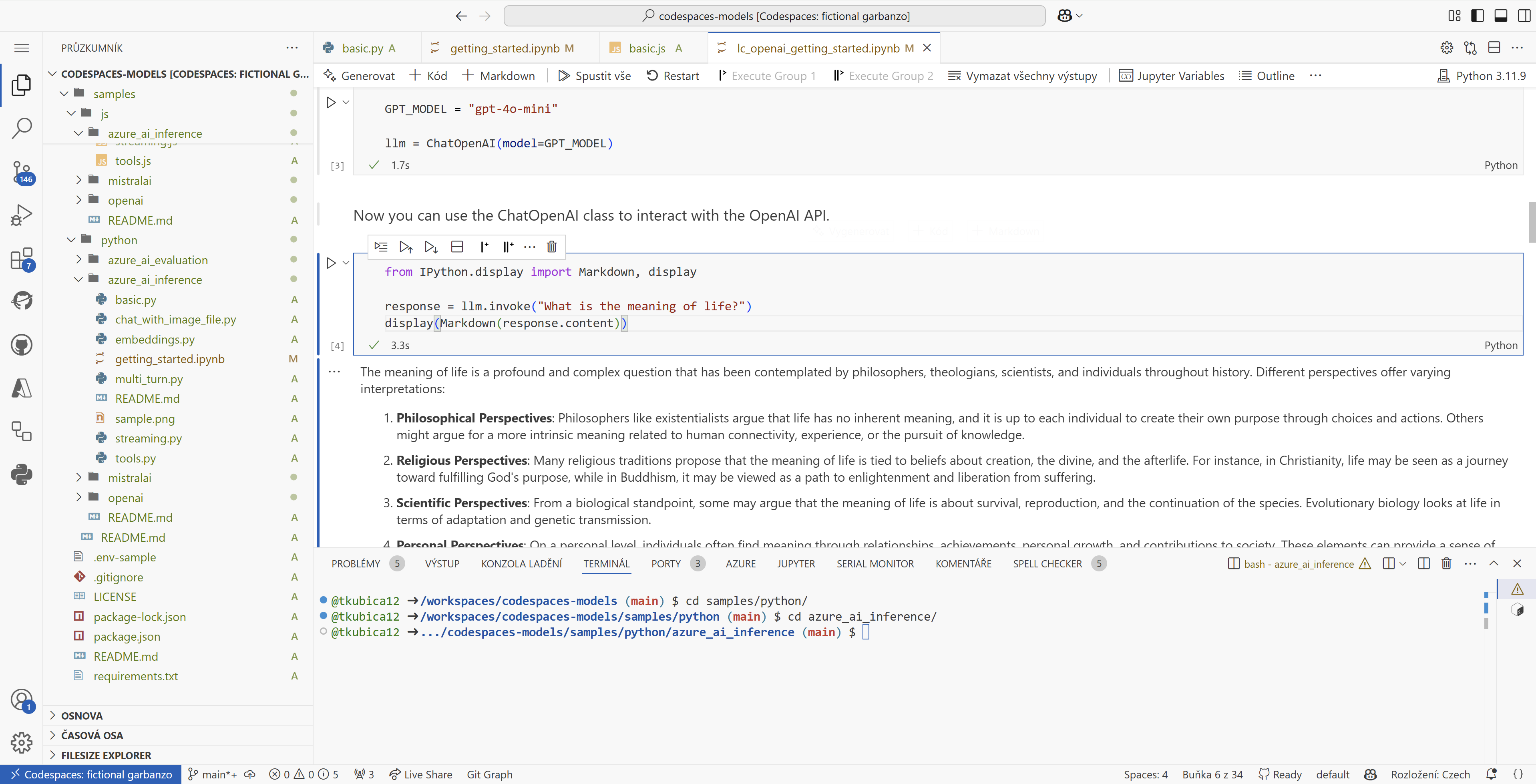

Nebo chcete použít framework jako je LangChain nebo LlamaIndex?

Samozřejmě v CodeSpaces i přes web funguje Copilot, takže s kódováním pomůže.

GitHub Copilot i ve verzi Free vám usnadní první vývojářské krůčky do světa generativních AI modelů - zkuste si.